La inteligencia artificial avanza a una velocidad que ni los más optimistas imaginaron. Y, mientras aplaudimos su uso para mejorar procesos, hay una realidad incómoda: la IA también estaba siendo entrenada para atacar.

Hoy ya existían modelos capaces de escribir malware indetectable, generar phishing hiperrealista y automatizar campañas que antes requerían meses de trabajo humano.

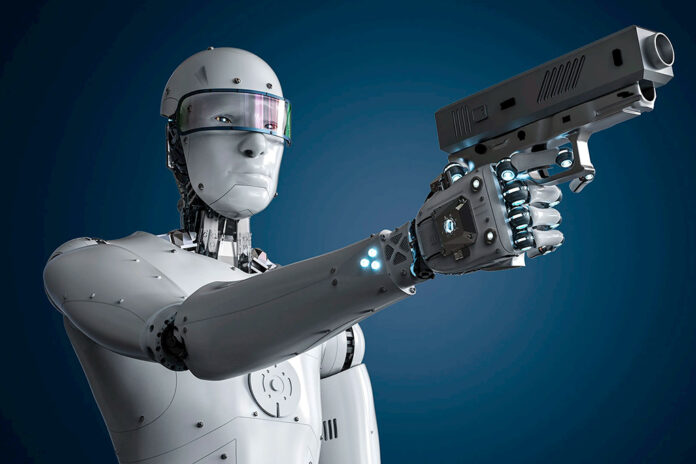

La llamada IA ofensiva era el nuevo “hacker incansable”: barato, veloz y escalable.

El debate no era futurista, era actual. ¿Qué pasaba cuando cualquier persona con mínimos recursos accedía a herramientas que antes solo tenían los ciberdelincuentes más sofisticados? ¿Estábamos listos para enfrentar ataques diseñados por máquinas que aprendían de nuestros propios errores de seguridad?

Necesitábamos poner este tema en la mesa ahora: regulación, ética y, sobre todo, innovación defensiva que estuviera a la altura.

Si la IA ofensiva escalaba y seguíamos con los mismos reflejos lentos, no hablaríamos de ataques aislados, sino de un ecosistema digital permanentemente bajo asedio.

La pregunta era simple: “¿Queremos ser espectadores de cómo la IA potencia al ciberdelincuente o vamos a dar el salto para usarla como escudo y no como arma en contra nuestra?”