Microsoft presentó Maia 200, un acelerador de inferencia de inteligencia artificial diseñado para mejorar de forma significativa la eficiencia económica en la generación de tokens.

El nuevo chip está construido sobre el proceso de 3 nanómetros de TSMC e incorpora núcleos tensoriales nativos FP8 y FP4, junto con un sistema de memoria rediseñado que combina 216 GB de HBM3e y 272 MB de SRAM integrada.

Según la compañía, Maia 200 ofrece hasta tres veces el rendimiento FP4 del acelerador de tercera generación de Amazon y supera en FP8 al TPU de séptima generación de Google.

Además, logra un 30% más de rendimiento por dólar frente al hardware más avanzado de su flota actual.

Maia 200 forma parte de la infraestructura heterogénea de IA de Microsoft y dará soporte a múltiples modelos, incluidos los más recientes GPT-5.2 de OpenAI.

También será utilizado por el equipo de Microsoft Superintelligence para generación de datos sintéticos y aprendizaje por refuerzo.

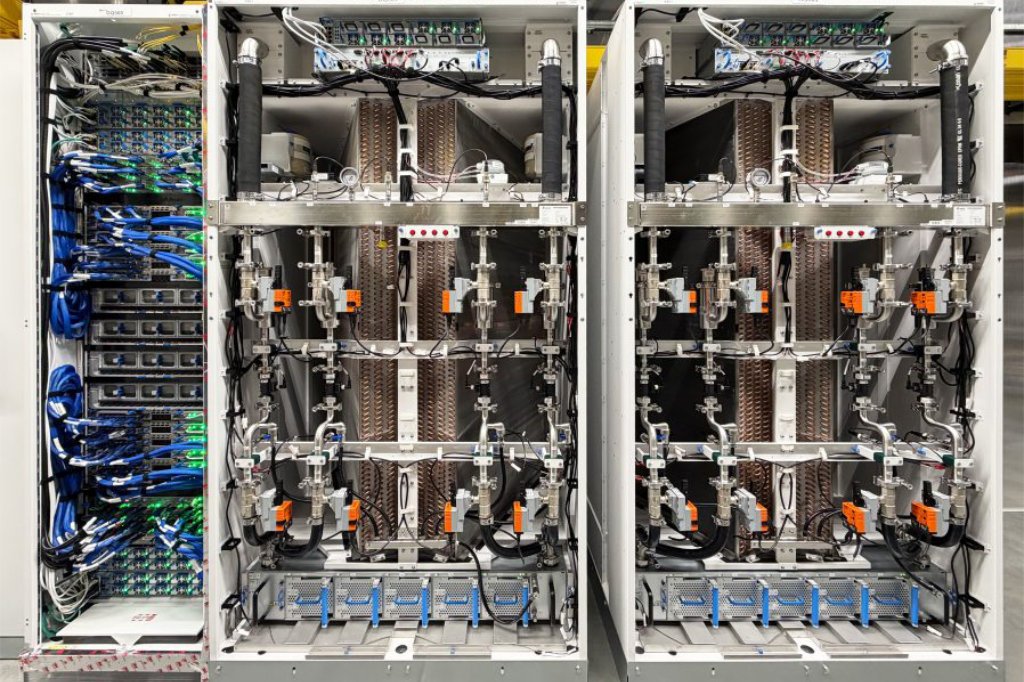

El acelerador ya se encuentra desplegado en la región de centros de datos US Central, cerca de Des Moines, Iowa, y próximamente llegará a US West 3, en las cercanías de Phoenix, Arizona, además de futuras regiones.

Diseñado específicamente para inferencia de IA, cada chip integra más de 140 mil millones de transistores y puede entregar más de 10 petaFLOPS en FP4 y más de 5 petaFLOPS en FP8, dentro de un consumo energético de 750 W.

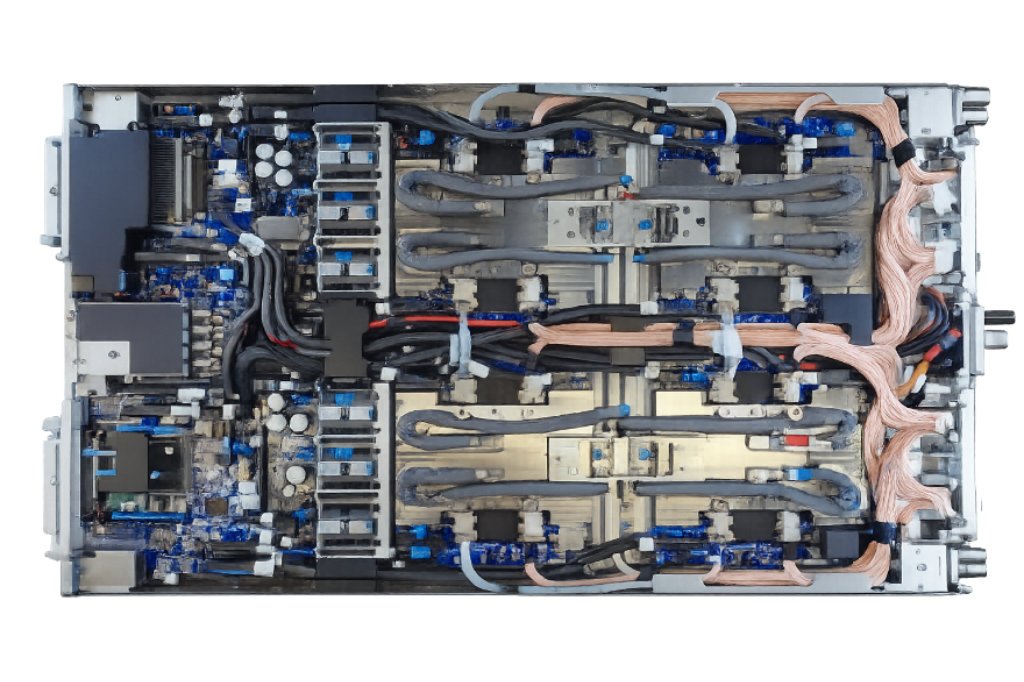

La arquitectura pone un énfasis particular en el movimiento eficiente de datos. Para ello, Maia 200 incorpora un subsistema de memoria optimizado, motores DMA especializados y una estructura de red en chip pensada para alto ancho de banda.

A nivel de sistemas, Maia 200 introduce una red de escalado de dos niveles basada en Ethernet estándar, lo que permite clústeres de hasta 6.144 aceleradores con operaciones colectivas predecibles y de alto rendimiento.

Dentro de cada bandeja, cuatro aceleradores Maia se conectan mediante enlaces directos no conmutados, optimizando la comunicación local y reduciendo el consumo energético total en la infraestructura de Azure.

Un aspecto central del desarrollo fue el enfoque nativo en la nube. Microsoft validó gran parte del sistema antes de la disponibilidad final del silicio, utilizando entornos de simulación pre-silicio para optimizar hardware, redes y software de forma integrada.

Este enfoque permitió que los primeros modelos de IA funcionaran sobre Maia 200 pocos días después de la llegada del primer chip empaquetado, reduciendo a menos de la mitad el tiempo habitual entre el primer silicio y el despliegue en centros de datos.

Finalmente, la firma invitó a desarrolladores, startups y académicos a registrarse en la vista previa del SDK de Maia 200, que incluye soporte para PyTorch, compilador Triton, programación de bajo nivel y herramientas para optimizar costos y rendimiento desde etapas tempranas.